GPT模型的更新迭代,其展现了惊人能力,让AI技术再次进入了一个前途可期的关键点。

而支撑起GPT模型的能力突破的,不仅仅是AI算法和数据,更是硬件提供的强大AI算力。

当地时间3月21日,英伟达首席执行官黄仁勋将OpenAI的ChatGPT称为人工智能的“iPhone时刻”。

并在该公司的春季GTC大会上宣布了专为其设计的推理GPU(图形处理器)。

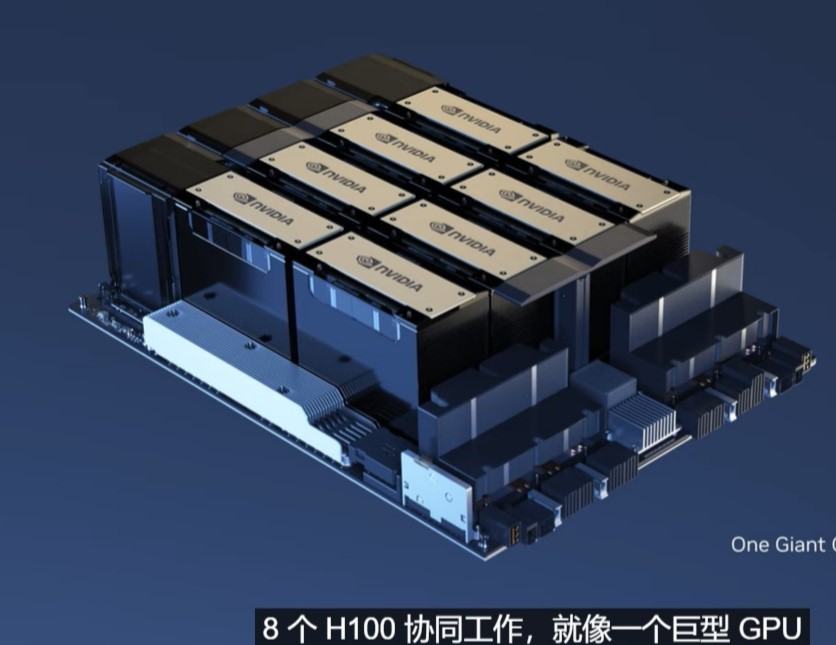

其中最主要的是H100 NVL,它将英伟达的两个H100 GPU拼接在一起,以部署像 ChatGPT这样的大型语言模型(LLM)。

当前唯一可以实际处理ChatGPT的GPU是英伟达HGX A100。

与前者相比,现在一台搭载四对H100和双NVLINK的标准服务器速度能快10倍,可以将大语言模型的处理成本降低一个数量级。

H100不是新的GPU,英伟达在一年前的GTC上展示了其Hopper架构,并在各种任务中加速AI推理。

推理是机器学习程序部署的第二阶段,此时运行经过训练的程序以通过预测来回答问题。

英伟达表示,H100 NVL附带94GB内存,与上一代产品相比,H100的综合技术创新可以将大型语言模型的速度提高30倍。

PC时代的芯片王者是Intel,那么AI时代的芯片王者就是Nvidia。

对于AI模型的性能,最迫切的需求不是在训练,而是在推理上,毕竟训练可以离线、增量,而推理必须实时。

面对海量用户的并发请求,能在用户无感的情况下给出推理结果,AI模型简直能做的事不要太多。

硬件的演进和对应的下层软件库的优化,才能带来数量级的提升。

这次GTC,Nvidia 发布了AI超级计算服务DGX Cloud、突破性的光刻计算库cuLitho、加速企业创建大模型和生成式AI的云服务NVIDIA AI Foundations等。

以及与Quantum Machines合作推出了全球首个GPU加速量子计算系统。

但重点还是针对推理:H100 NVL,它将英伟达的两个H100 GPU拼接在一起,以部署像 ChatGPT这样的LLM。

现在一台搭载四对H100和双NVLINK的标准服务器速度能比 HGX A100 快10倍,可以将 LLM 的处理成本降低一个数量级。

AI的理论发展的越快、模型越来越大、应用场景越广,对Nvidia来说越是利好,AI对算力的要求非常之高,只能说Nvidia赢麻了。

点击收藏本站,随时了解时事热点、娱乐咨询、游戏攻略等更多精彩文章。