GPU图形产品即将再次面临新的缺货涨价风险,这次不是拜挖矿所致,而是AI人工智能,尤其是最近大火的生成式聊天机器人ChatGPT。

一般来说,像 HBM3 这样的显存由于需求量不是很大,因此价格不会出现大波动,当然供应量也不低,毕竟制造成本高昂,产能也有限,基本上是供需平衡。

然而现在由于 ChatGPT 的火爆,导致 NVIDIA 的计算卡供不应求,使得 HBM3 显存出现了严重短缺的情况,由此导致三星以及海力士作为 HBM3 显存的供应商报价不断提升,远超平均报价水准。

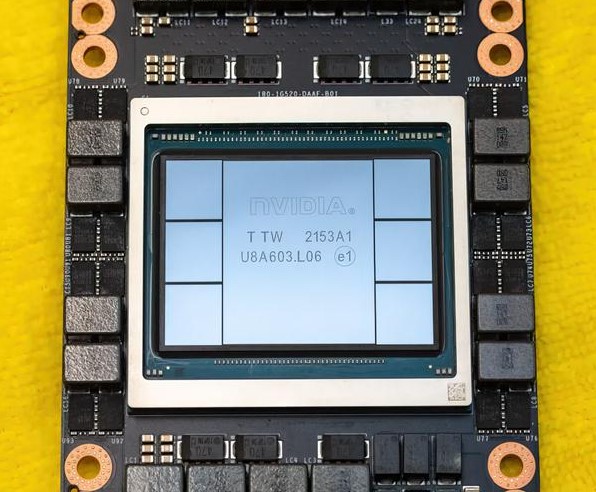

由于 ChatGPT 的火爆,导致作为深度学习训练工具的英伟达计算卡供不应求,比如说 A100 计算卡配备的是 80GB 的 HBM2e 显存,而新一代的 Ada 计算卡更是配备了 HBM3 显存。

英伟达也加大订单给三星和海力士,让他们加班加点生产 HBM3 显存,当然成本也是节节攀升,据悉 HBM3 显存目前的价格已经是最出色的 DRAM 存储 5 倍的价格,但还是供不用求,看起来英伟达这一次下单的量的确十分地恐怖。

得益于超高带宽,HBM3已经得到NVIDIA计算卡H100搭载,Intel前不久推出的x86处理器Xeon Max上面也使用了HBM2e。

当然,三星也有存算一体这样的解决方案,比如HBM-PIM(Aquabolt-XL)芯片,可提供1.2T算力,SK海力士去年开发出具备计算功能的GDDR6-AiM,外界预计AI将至少在图形计算、加速器这一领域拯救低迷的DRAM需求。

但随之而来另一个隐忧是,业内对AI包括机器学习训练的跟风,或将导致GPU芯片再度短缺。据了解,为了创建和维持ChatGPT所需的人工智能分析数据的庞大数据库,开发者使用了10000个英伟达的GPU进行相关的训练。

目前海力士是全球 HBM3 显存的主力生产商,占据了 60-70% 的市场,而三星则凭借着强大的研发实力以及资金投入,现在也在 HBM 显存市场上如鱼得水。考虑到不断接入的 ChatGPT 的需求,有关公司对于计算卡的需求也呈现出暴增的态势。

据悉目前已经有超过 25000 块英伟达计算卡加入到了训练之中,而假如说所有的互联网企业都在搜索引擎中加入 ChatGPT 这样的机器人,那么计算卡以及相应的服务器的需求量将会达到 50 万块,远远超过现在的产能。

而目前为了满足当前服务器的需求,ChatGPT的开发商OpenAI已使用了约2.5万个英伟达的GPU,随着需求的增加未来预计还会增加。

每有1亿活跃用户,ChatGPT就需要13.5EPLOPS的算力,大约是6.9万台NVIDIA DGX A100 80G服务器支撑,而目前全球的算力也只能支撑1亿日均上线人数。

有专业人士推算,如果谷歌搜索全面集成Bard平台AI技术,需要512820台A100 HGX服务器,将需要超过410万个A100 GPU。

点击收藏本站,随时了解时事热点、娱乐咨询、游戏攻略等更多精彩文章。